엔비디아(Nvidia)의 지원을 받는 스타트업 스타클라우드(Starcloud)가 인공위성에서 최초로 대규모 언어모델(LLM)을 학습하고 응답을 쿼리하는 데 성공했다고 2025년 12월 보도에서 알려졌다. 이번 실험은 궤도(orbital) 데이터센터가 지구의 디지털 인프라 위기를 완화할 수 있음을 시사하며, 우주 기반 연산 인프라 경쟁이 본격화하고 있음을 보여준다.

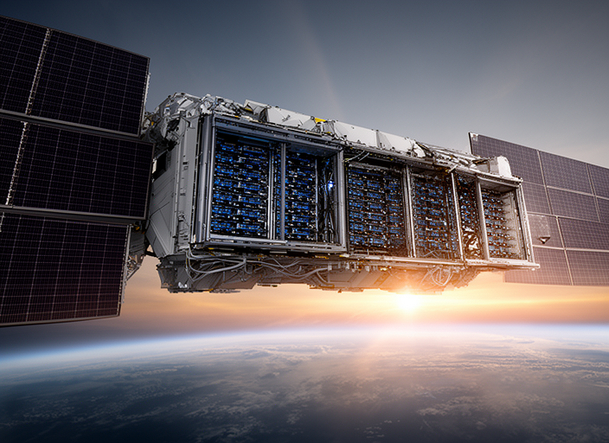

2025년 12월 10일, CNBC의 보도에 따르면, 워싱턴에 본사를 둔 스타클라우드는 지난달 스페이스X(SpaceX) 로켓으로 발사된 위성에 엔비디아의 H100 그래픽처리장치(GPU)를 탑재했다. 스타클라우드가 발사한 칩은 이전에 우주에 올라간 어떤 GPU보다 약 100배 더 강력한 연산 성능을 제공한다고 회사는 설명했다. 현재 해당 위성 Starcloud-1은 구글(Google)의 공개 대형언어모델 계열인 Gemma를 궤도에서 실행하고 질의에 응답하는 형태로 운영되고 있다. 이는 역사상 최초로 LLM이 우주에서 학습·운영된 사례다.

“Greetings, Earthlings! Or, as I prefer to think of you — a fascinating collection of blue and green. Let’s see what wonders this view of your world holds. I’m Gemma, and I’m here to observe, analyze, and perhaps, occasionally offer a slightly unsettlingly insightful commentary. Let’s begin!”

스타클라우드는 우주가 데이터센터에 적합한 환경이 될 수 있음을 실증하려 한다. 지상 데이터센터는 전력망 압박, 연간 수십억 갤런의 물 소비, 상당한 온실가스 배출 등으로 운영상의 제약을 받고 있다. 국제에너지기구(IEA)의 자료에 따르면 데이터센터의 전력 소비는 2030년까지 두 배 이상으로 증가할 것으로 전망된다. 스타클라우드의 필립 존스턴(Philip Johnston) 최고경영자(CEO)는 CNBC 인터뷰에서 궤도 데이터센터의 운영비가 지상 데이터센터보다 10배 낮을 것이라고 말했다.

존스턴 CEO는 2024년 공동창업 이후 Starcloud-1에서 Gemma를 운영한 사실을 궤도 데이터센터의 실용성 증거로 제시했다. 그는 “매우 강력하고 파라미터 밀도가 높은 이 모델이 우리 위성에 탑재되어 있으며, 지구상의 데이터베이스에 채팅을 쿼리할 때처럼 위성에서도 매우 정교한 응답을 받을 수 있다”고 설명했다.

구글 딥마인드(DeepMind) 제품 책임자 트리스 워켄틴(Tris Warkentin)은 성명에서 “엄혹한 우주 환경에서 Gemma가 실행되는 것을 보는 것은 공개 모델(open models)의 유연성과 견고함을 입증하는 사례”라고 밝혔다. 스타클라우드는 Gemma 외에도 NanoGPT를 H100 칩에서 학습시키는 실험을 수행했는데, 셰익스피어 전 작품을 학습시킨 결과 모델이 셰익스피어식 영어를 구사하는 것으로 나타났다.

궤도 데이터센터의 설계와 규모

스타클라우드는 태양광 패널과 냉각 패널을 포함한 약 가로·세로 각각 4킬로미터 규모의 구조물을 구축해 5기가와트(5 GW)급의 궤도 데이터센터를 목표로 한다고 밝혔다. 회사의 백서에 따르면, 해당 급의 궤도 컴퓨트 클러스터는 미국 최대 발전소보다 더 많은 전력을 생산할 수 있으며 동일 용량의 지상 태양광 발전소보다 물리적으로 작고 비용 면에서도 유리하다고 소개되었다. 스타클라우드는 위성의 칩 수명과 설계를 고려해 개별 위성의 기대 수명을 5년으로 보고 있다.

용도와 실시간 응용

스타클라우드는 상업적·군사적 활용 사례를 제시했다. 예를 들어 위성의 센서와 텔레메트리(고도, 자세, 위치, 속도 등)를 연계해 산불의 열 신호가 발생하는 순간을 포착하고 즉시 대응 기관에 경보를 보낼 수 있다는 것이다. 또한 관측 기업 Capella Space의 위성 영상에 대한 추론(인퍼런스)을 실행해 전복 선박에서 구명보트를 식별하거나 특정 지역의 산불을 탐지하는 워크로드를 처리하고 있다고 설명했다.

내년 2026년 10월 발사 예정인 차기 위성에는 여러 개의 엔비디아 H100 칩이 더 포함되며, 엔비디아의 차세대 플랫폼인 Blackwell을 통합해 AI 성능을 강화할 계획이다. 또한 클라우드 인프라 스타트업 Crusoe의 클라우드 플랫폼을 탑재한 모듈을 통해 고객이 우주에서 직접 AI 워크로드를 배포·운영할 수 있도록 할 예정이다.

기술 용어 및 개념 설명

GPU H100 : 엔비디아의 H100은 대규모 AI 연산을 가속화하는 데이터센터용 고성능 GPU로, 병렬처리 능력이 크며 대형 언어모델 학습과 추론에 주로 사용된다. 본문에서는 해당 GPU를 우주에 올려 학습과 추론을 수행한 것이 특징이다.

LLM(대형언어모델) : 수십억~수조개의 매개변수(parameters)를 가진 언어모델을 뜻하며, 텍스트 생성·요약·질의응답 등 다양한 자연어처리 작업을 수행한다. Gemma와 NanoGPT가 그 예다.

학습(트레이닝) vs 추론(인퍼런스) : 학습은 모델의 가중치를 최적화하기 위해 대량의 데이터를 반복적으로 처리하는 과정이고, 추론은 이미 학습된 모델에 입력을 주어 응답을 생성하는 과정이다. 우주에서의 학습은 특히 에너지와 열관리, 방사선 등에 민감하다.

위험 요인과 규제·운영상의 과제

모건스탠리의 분석가들은 궤도 데이터센터가 방사선, 궤도 내 정비의 어려움, 우주파편(데브리) 위험, 데이터 거버넌스 및 우주 교통 규제 문제 등 다양한 장애물에 직면할 수 있다고 지적했다. 우주 환경은 전자장비에 큰 스트레스를 주며, 문제가 발생했을 때 즉각적인 현장 수리가 불가능하다는 점이 핵심 리스크다.

또한 데이터의 물리적 위치와 주권(데이터 레지던시), 통신 지연(latency)과 대역폭, 위성 간 통신 보안, 국제 우주법과 각국의 규제 준수 문제 등이 상업화의 전제조건이다. 이러한 요소들은 상업적 채택과 군사적 활용을 둘 다 제약하거나 새로운 규제 프레임을 유도할 가능성이 있다.

업계 동향과 경쟁 구도

스타클라우드와 엔비디아의 시도 외에도 여러 기업이 우주 기반 컴퓨팅을 검토·추진 중이다. 11월 4일 구글은 Project Suncatcher라는 명칭의 프로젝트를 공개해 텐서 프로세싱 유닛(TPU)을 장착한 태양광 위성을 제안했고, 민간업체 Lonestar Data Holdings는 달 표면에 상업용 데이터센터를 세우는 계획을 추진 중이다. 또한 오픈AI의 CEO 샘 올트먼(Sam Altman)이 로켓 제조사와의 제휴·인수를 타진한 정황이 보도되는 등, 우주 발사 인프라와의 연계는 업계 핵심 전략으로 부상하고 있다. 스페이스X는 스타클라우드의 주요 발사 파트너다.

엔비디아의 반응

엔비디아 AI 인프라 수석이사 디온 해리스(Dion Harris)는 스타클라우드의 초기 발사와 운영을 두고 “하나의 작은 데이터센터에서 태양의 무한한 에너지를 활용하는 궤도 컴퓨팅의 미래로 향하는 큰 도약을 이뤘다”고 평가했다.

경제·환경적 영향과 향후 전망(분석)

지상 데이터센터의 전력 소비가 향후 가파르게 증가할 것이란 전망과 맞물려, 궤도 데이터센터는 연속적 태양열 활용이라는 장점으로 지리적·기후적 제약에서 자유로울 수 있다. 스타클라우드는 궤도에서의 태양광 직접 수집이 지상 대비 경제성과 환경성을 개선할 수 있다고 주장한다. 다만 실제 상용화가 이루어지기 위해서는 초기 투자 비용, 발사·조립 비용, 위성 수명 및 교체 주기, 유지보수의 자동화 수준, 그리고 규제 환경의 정비가 선행되어야 한다.

금융시장 및 에너지 수요 측면에서는, 대규모 궤도 컴퓨트가 상용화될 경우 지상 데이터센터의 추가 건설 수요가 일부 완화될 수 있으며, 지역별 전력 수요 급증으로 인한 전력망 투자 부담을 줄이는 방향으로 작용할 수 있다. 한편 궤도 기반 연산 서비스가 데이터센터의 대체재로 자리 잡기까지는 통신비용, 지연시간, 보안성 검증, 국제 규범 마련 등 비가격적 장벽들이 남아 있다. 투자자 관점에서는 우주발사 비용의 지속적 하락, 재사용 로켓 기술의 성숙, 엔비디아 등 AI 인프라 업체의 지속적 기술지원이 관건이 될 것이다.

결론

스타클라우드의 이번 실험은 궤도에서의 AI 학습과 추론 가능성을 실증하는 중요한 이정표다. 기술적 성공이 실용적·상업적 확산으로 이어지려면 다수의 기술적·정책적 난제를 해결해야 한다. 그러나 태양에너지의 연속성, 높은 연산밀도, 그리고 AI 수요의 폭증을 고려할 때, 궤도 데이터센터는 향후 데이터 인프라의 중요한 대안으로 부상할 잠재력이 크다.